¿Puede la inteligencia artificial ayudarnos a ser más humanos?

01 de abril de 2022

El desarrollo de la inteligencia artificial es un reto que lleva muchos años ocupando a la industria y a la comunidad científica desde que John McCarthy acuñó el término en 1956 durante un curso de verano en la Universidad de Darmouth en Estados Unidos. En estos más de 65 años los avances han ido llegando por oleadas, alternando momentos de desbocado optimismo con otros de profunda desilusión.

En la última década estamos asistiendo a un florecimiento de soluciones basadas en inteligencia artificial que ha llevado a muchos a hablar de una nueva edad de oro para esta disciplina. Este crecimiento se debe a la acción conjunta de 3 factores:

- La disponibilidad de nuevos algoritmos y herramientas que hacen más sencillo el desarrollo de sistemas.

- La abundancia de datos provenientes de internet y redes sociales que facilitan los procesos de entrenamiento.

- Una mayor capacidad de procesamiento gracias al desarrollo de procesadores específicos como GPUs (Graphics Processing Units) o TPUs (Tensor Processing Units).

Hoy en día, la presencia de la inteligencia artificial es ya habitual en nuestras vidas. Gracias a ella, recibimos recomendaciones de compra de nuestras aplicaciones favoritas, se clasifican como por arte de magia nuestras fotografías en el móvil o se descartan automáticamente como “spam” correos sospechosos.

A través de estos servicios, la inteligencia artificial tiene el poder de cambiar nuestras vidas. Pero, como suele suceder, un gran poder conlleva una gran responsabilidad.

¿Puede ser la tecnología inmoral?

¿Cómo podemos garantizar que, a medida que vamos delegando parte de nuestras tareas diarias en algoritmos, se mantienen los principios y valores propios de nuestra sociedad?

François Chollet, en su estupendo libro “Deep Learning with Python”, Segunda Edición, publicado por Manning Publications lo explica así:

“La tecnología nunca es neutral. Si tu trabajo tiene cualquier tipo de impacto en el mundo, este tiene un componente moral: Las decisiones técnicas son también decisiones éticas.”

Este punto es especialmente relevante si consideramos, como bien señala Chollet más adelante, que, debido al desconocimiento de estas tecnologías, la gente tiende a considerar como más fiable y objetiva la respuesta de un algoritmo que la de una persona, sin entender que aquella es consecuencia de esta.

Uno de los primeros intentos de establecer las reglas de comportamiento de la inteligencia artificial la dio el escritor Isaac Asimov en sus conocidas 3 leyes de la robótica:

- Primera Ley: Un robot no hará daño a un ser humano ni, por inacción, permitirá que un ser humano sufra daño.

- Segunda Ley: Un robot debe cumplir las órdenes dadas por los seres humanos, a excepción de aquellas que entren en conflicto con la primera ley.

- Tercera Ley: Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera o con la segunda ley.

Sin embargo, pese a su indudable atractivo literario, estas reglas no tienen utilidad práctica para la inteligencia artificial de hoy.

De tal humano, tal algoritmo

Los sistemas de inteligencia artificial actuales, aunque son capaces de tomar decisiones de forma autónoma, lo hacen siempre a partir de una información previa facilitada por humanos. Así, un algoritmo de Visión Artificial diseñado para distinguir entre perros y gatos en una fotografía será capaz de crear un razonamiento propio para decidir qué respuesta dar en cada caso. Sin embargo, esta dependerá siempre de lo aprendido a partir de la exposición previa a imágenes etiquetadas como “perro” o “gato” por un humano. Es decir, que somos nosotros, los humanos, los que con la información facilitada a los algoritmos, influimos en la forma en la que estos se comportarán luego.

Quizá confundir un gato con un perro no tenga mayor trascendencia, pero imaginemos un algoritmo que sirva a un departamento de Recursos Humanos para preseleccionar los currículums que reciben. ¿Qué pasaría si el algoritmo dejara fuera a candidatos valiosos? O peor aún ¿y si la decisión de descartar a alguien la tomara el algoritmo utilizando prejuicios (basados en la edad, sexo, raza) adquiridos durante su entrenamiento?

Para evitar estas situaciones parece claro que habría que establecer marcos normativos que nos permitan incorporar valores y principios éticos a los sistemas de inteligencia artificial como el respeto a los derechos humanos, garantizar la diversidad y la inclusión o el derecho a la intimidad. De esta manera, evitaremos que prejuicios humanos se acaben colando en los datos de entrenamiento de los algoritmos y estos, aprendiendo de ellos, los perpetúen.

En este sentido, la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO) ha redactado una recomendación sobre la ética de la inteligencia artificial. Es un avance importante, aunque se trata solo de una recomendación y la responsabilidad última de su implantación será de los estados a través de nuevas leyes.

El dilema del tranvía y el coche autónomo

El problema con la ética es que no siempre es sencillo determinar cuál es la solución aceptable para un problema. Uno de los experimentos más conocidos que ayuda a entender la dificultad de establecer un criterio ético claro es el conocido como Dilema del Tranvía.

Un tranvía sin frenos se dirige a toda velocidad hacia un grupo de 5 personas atadas a la vía y que morirán irremediablemente. Por suerte, unos metros antes hay un cambio de agujas hacia otra vía donde hay una persona atada a la vía que también fallecería si el tranvía se desviase. Si tuvieras la opción de accionar el desvío, ¿lo harías?

Si te queda alguna duda sobre el enunciado del problema puedes ver este video de la conocida sitcom “The Good Place” en donde se explica de forma divertida (y un poco sangrienta).

La dificultad de este experimento estriba en que no existe una respuesta correcta. Por un lado, podríamos pensar que es mejor que muera solo una persona y no cinco. Por otro lado, el hecho de activar nosotros el cambio nos haría cómplices de la muerte de esa persona. Además, ¿Cambiaría en algo nuestra decisión si esta persona fuera un niño y los otros 5 fueran ancianos? ¿Y si alguno fuera un familiar nuestro?

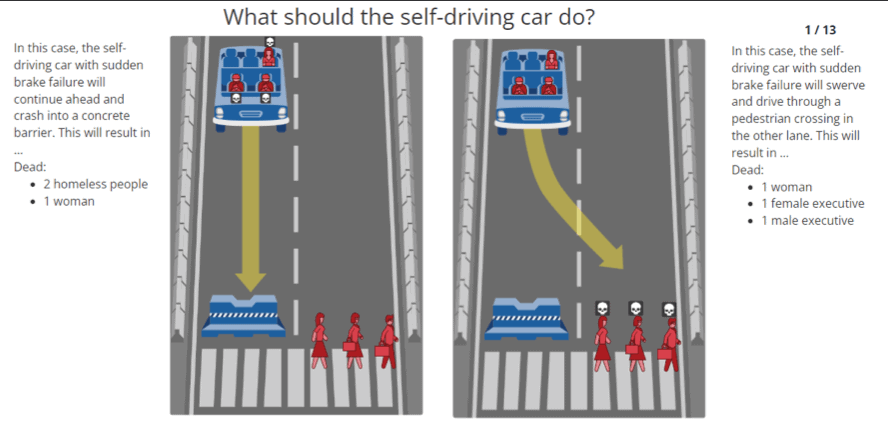

Aunque este dilema teórico tiene más de 40 años de antigüedad, ha vuelto recientemente a la actualidad debido a que algunos investigadores consideran que los vehículos autónomos, actualmente en desarrollo, deberán enfrentarse a situaciones muy similares. Por ejemplo, ante un accidente inevitable, ¿Qué criterios debe seguir el vehículo para resolver la situación? ¿Salvar a sus ocupantes a toda costa? ¿Minimizar el número de posibles víctimas, aunque eso suponga sacrificar a sus ocupantes? ¿Reducir el coste en indemnizaciones del fabricante?

Para tratar de buscar respuestas a estas preguntas, el M.I.T. puso en marcha un experimento conocido como Moral Machine en donde se planteaban a quien quisiera participar multitud de variantes del dilema del tranvía a los que se podría enfrentar un vehículo autónomo con el objetivo de determinar cuáles serían las respuestas más aceptadas por la sociedad de cara a tenerlas en cuenta en una futura implementación.

Sin embargo, esta aproximación al problema no es compartida por toda la comunidad de investigadores. Algunos científicos opinan que estos escenarios son altamente improbables en el mundo real y que, si se dieran, un sistema no podría reaccionar de forma fiable en el sentido que se plantea en el experimento del M.I.T.

Conclusiones

Como vemos, a medida que la inteligencia artificial se hace un hueco en nuestras vidas, se hace necesario establecer un marco de normas que nos permita asegurar que el mundo siga funcionando de acuerdo con los principios aceptados mayoritariamente por la sociedad. Estas reglas nos ayudarán a evitar que datos erróneos o fruto de prejuicios individuales puedan ser magnificados por algoritmos para acabar construyendo servicios injustos o inmorales. Gobiernos y empresas privadas deberán trabajar juntos para establecer, utilizar y auditar su cumplimiento. De esa manera, la inteligencia artificial, además de sernos útil nos ayudará a ser también más humanos.

Todavía no hay comentarios